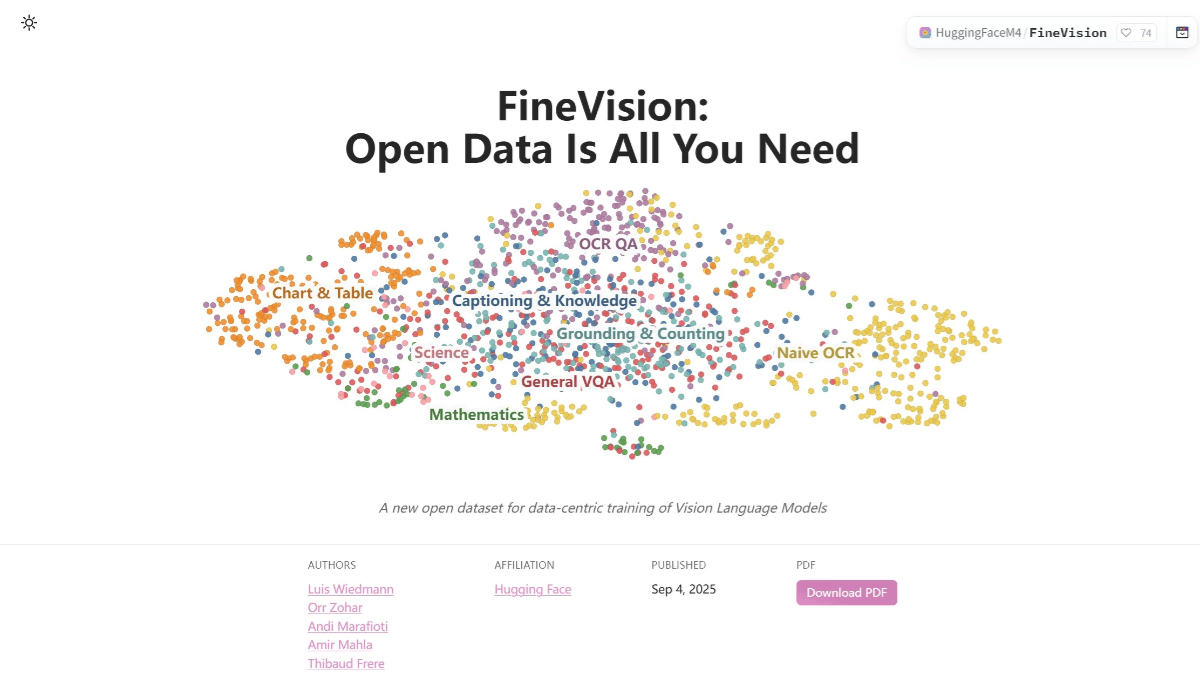

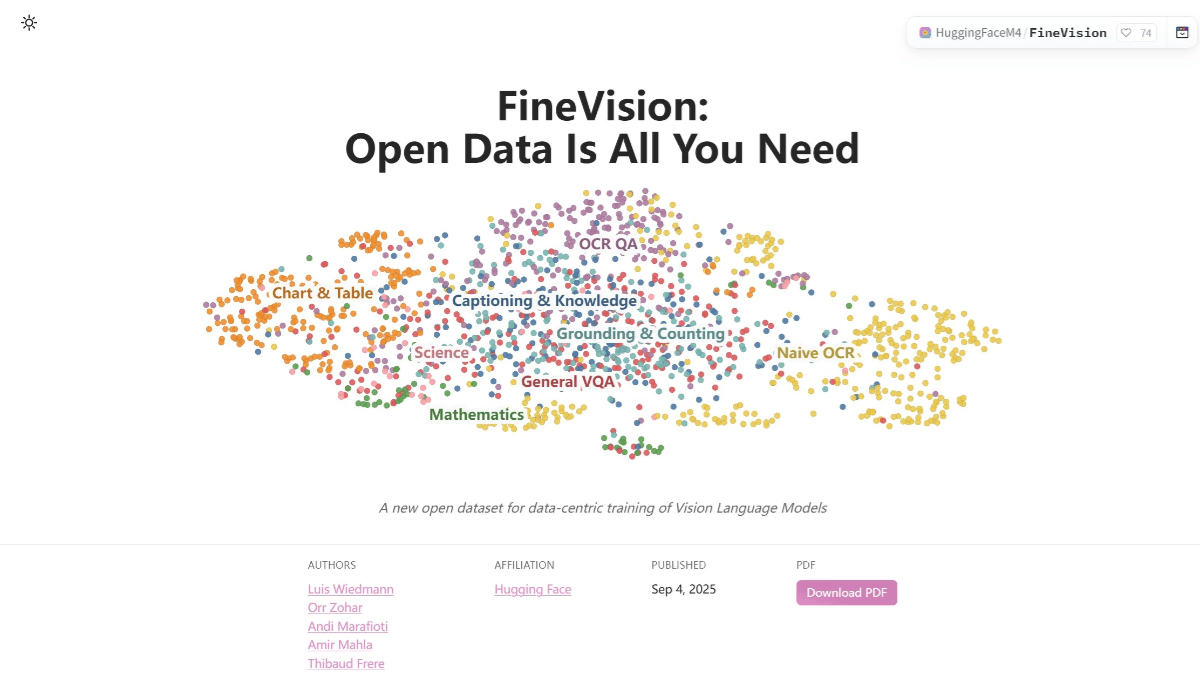

FineVision 是 Hugging Face 开源的视觉语言数据集,为训练先进的视觉语言模型。包含 1730 万张图像、2430 万个样本、8890 万轮对话和 95 亿个答案标记。数据集聚合了来自 200 多个来源的数据,具有多模态和多轮对话的特点,支持视觉和语言的结合。每张图像都配有文本标题,有助于模型理解和生成自然语言。FineVision 在 10 项基准测试中帮助模型平均提升了超过 20% 的性能。使用 Hugging Face 的 datasets 库可以轻松加载和使用数据集。

>>展开阅读

最近火爆全网的 AI 神器「Nano Banana」是谷歌推出的 Gemini 2.5 Flash Image 图像模型,可以生成超逼真手办人像,还支持场景换背景,修复老照片、转换艺术风格等等。

>>展开阅读

HunyuanWorld-Voyager(简称混元Voyager)是腾讯发布的业界首个支持原生3D重建的超长漫游世界模型。是一种新颖的视频扩散框架,能从单张图片生成用户定义相机路径的3D点云序列,支持沿着自定义相机轨迹进行世界探索的3D一致场景视频生成,可生成对齐的深度和RGB视频,用于高效直接的3D重建。模型包含两个关键组件:世界一致视频扩散和长距离世界探索,通过高效的点剔除和自回归推理实现迭代场景扩展。提出了一个可扩展的数据引擎,用于生成RGB-D视频训练的可扩展数据。

>>展开阅读

这期对话把火力对准了一个不体面的真相:更聪明的“路由”和更苛刻的“成本”正重写 AI 商业化的脚本。嘉宾阵容极具冲突感——半导体观察者 Dylan Patel,前谷歌云/企业家 Guido Appenzeller,风投人 Erin Price-Wright,与主持人 Erik Torenberg 一起,从 GPT-5 的“没加大算力却更会分配算力”谈起,直指 OpenAI 把免费用户与重度用户放在同一条计价胶带上滚动切割的现实逻辑。

>>展开阅读

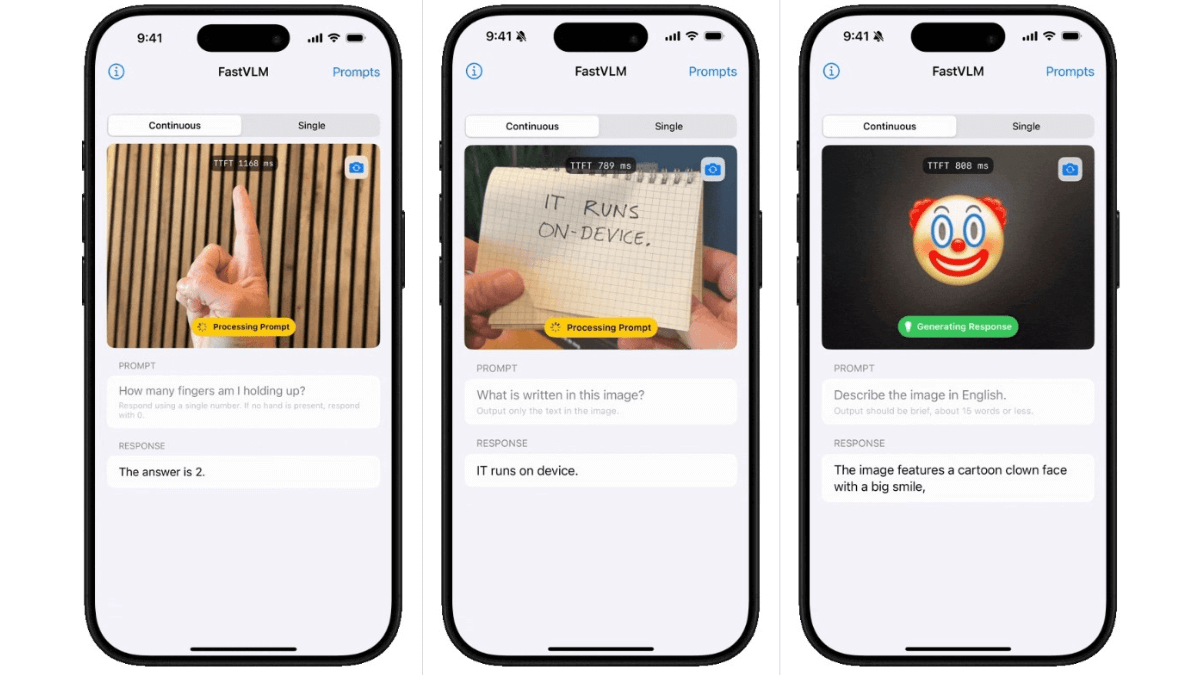

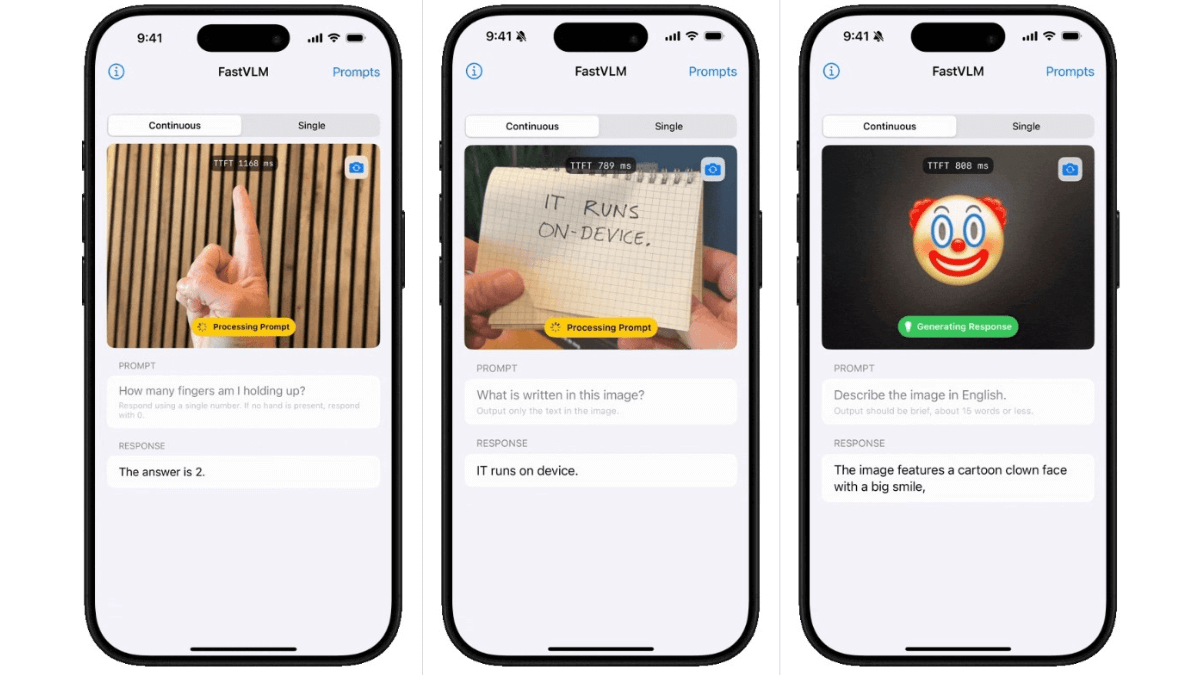

FastVLM(Fast Vision Language Model)是苹果公司推出的高效视觉语言模型。以FastViTHD混合视觉编码器为核心,融合了卷积和Transformer架构,可显著减少视觉token数量,降低编码时间和延迟。在处理高分辨率图像时,编码速度比同类模型快85倍,首次token生成时间(TTFT)提升了3.2倍,且视觉编码器尺寸更小,便于在移动设备上部署。

>>展开阅读

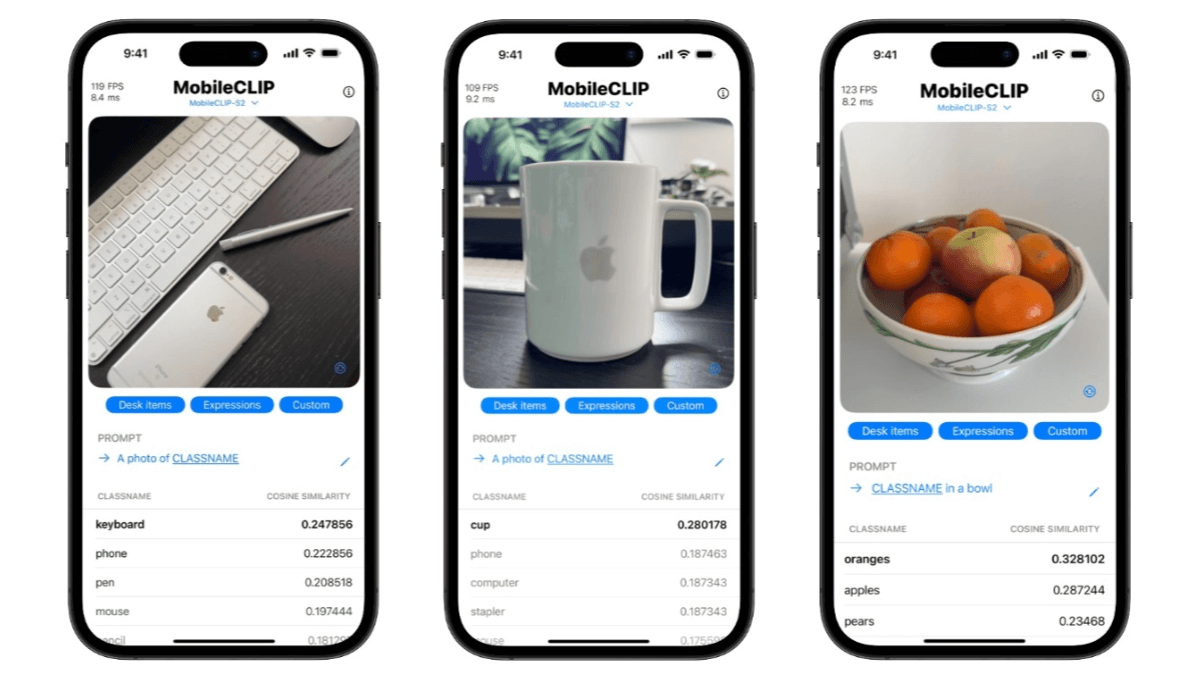

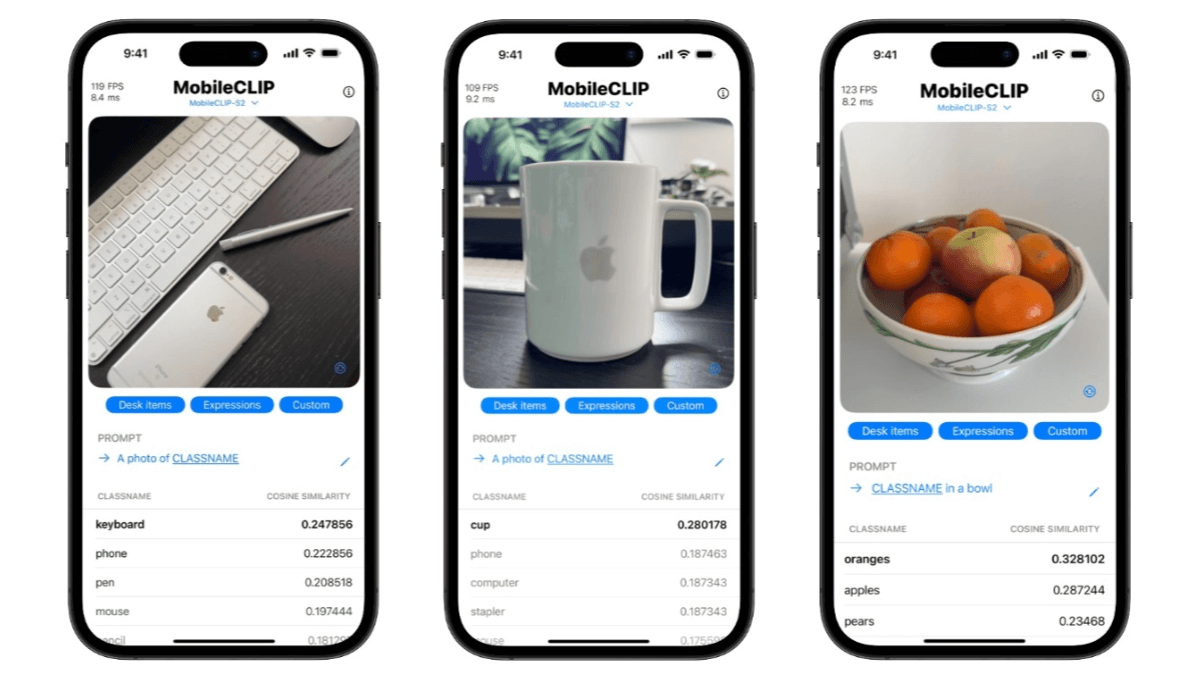

MobileCLIP2是苹果公司研究人员推出的高效端侧多模态模型,是MobileCLIP的升级版本。在多模态强化训练方面进行了优化,通过在DFN数据集上训练性能更优的CLIP教师模型集成和改进的图文生成器教师模型,进一步提升了模型性能。MobileCLIP2在零样本分类任务上表现出色,例如在ImageNet-1k零样本分类任务中,准确率较MobileCLIP-B提升了2.2%。MobileCLIP2-S4在保持与SigLIP-SO400M/14相当的性能的同时,模型规模更小,推理延迟更低。在多种下游任务中也展现了良好的性能,包括视觉语言模型评估和密集预测任务等。

>>展开阅读

gpt-realtime 是 OpenAI 推出的先进语音模型,支持直接处理音频,生成自然流畅的语音。模型支持多种语言和风格,能理解非语言线索,如笑声,能在不同语言间切换。模型在指令遵循和功能调用方面表现出色,准确率显著提升。模型支持图像输入,借助 Realtime API,可基于图像内容展开对话。gpt-realtime 适用客服、教育、个人助理等多个领域,能有效提升效率和用户体验。

>>展开阅读

Youtu-agent 是腾讯优图实验室开源的智能体框架,用在构建和运行自主智能体。框架在 WebWalkerQA 和 GAIA 基准测试中表现出色,准确率分别达到 71.47% 和 72.8%。框架开源友好,不依赖闭源模型,适合多种应用场景。Youtu-agent支持多种任务,如 CSV 分析、文献综述和文件组织等。基于 YAML 的配置和自动化设置,简化智能体的生成和部署。Youtu-agent 支持多种模型 API 和工具集成,具有灵活的架构,可广泛应用在数据分析、文件管理、内容生成等领域。

>>展开阅读

- «

- 1

- ...

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- ...

- 25

- »